Naarmate het gebruik van Generative AI (GenAI) toeneemt, neemt ook de bezorgdheid over mogelijk misbruik toe. Dit heeft geleid tot de roep om specifieke wet- en regelgevingskaders om een verantwoorde en duurzame ontwikkeling van GenAI te stimuleren.

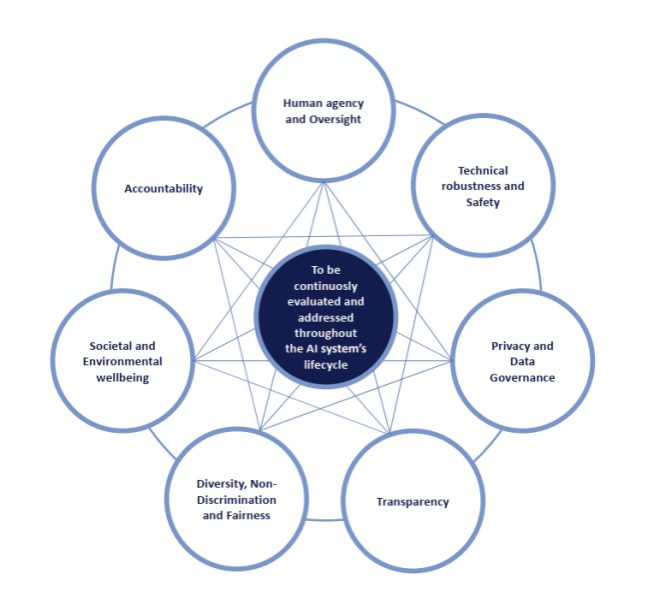

De Europese Commissie was een van de eersten die actie ondernam en publiceerde in 2019 haar “Ethical Guidelines for Trustworthy AI“. Deze richtlijnen benadrukken het belang van AI-systemen die voldoen aan wetten, zich houden aan ethische principes en technisch en sociaal robuust zijn. Er worden zeven fundamentele vereisten geïdentificeerd, die we in dit bericht kort beschrijven.

Menselijk Agentschap en Toezicht

Er is algemene overeenstemming over het feit dat elk AI-systeem mensen mondiger moet maken, hun rechten moet respecteren en menselijk toezicht mogelijk moet maken. GenAI stelt ons in dit opzicht echter voor unieke uitdagingen.

GenAI kan bijvoorbeeld “filterbubbels” creëren die de blootstelling van gebruikers aan verschillende perspectieven beperken en zo de mogelijkheid van menselijk toezicht beperken. Bovendien kan GenAI worden gebruikt voor kwaadaardige manipulatie door emotionele kwetsbaarheden uit te buiten om beslissingen te beïnvloeden of menselijke reacties na te bootsen, wat verwarring en zelfs misleiding kan veroorzaken.

Toegepast op sociale netwerken kunnen de augmentatieve vaardigheden van GenAI gebruikers misleiden, wat leidt tot een vertekend beeld van de werkelijkheid en verhoogde sociale druk.

Om de juiste balans te vinden tussen het immense potentieel van GenAI en de behoefte aan menselijke tussenkomst en toezicht, is voortdurend toezicht, onderzoek en de ontwikkeling van hulpmiddelen en beleid nodig die de autonomie van gebruikers bevorderen en mogelijke negatieve gevolgen beperken.

Technische robuustheid en veiligheid

De toenemende geavanceerdheid van GenAI roept vragen op over de veiligheid en betrouwbaarheid ervan. Een zeer actuele angst is dat GenAI bijdraagt aan de verspreiding van desinformatie en nepnieuws, waardoor de publieke opinie wordt beïnvloed en het vertrouwen in instellingen mogelijk wordt ondermijnd. Het creëren van overtuigende maar gemanipuleerde valse beelden van hooggeplaatste personen, deepfakes genoemd, is een van de grootste zorgen rond GenAI, omdat ze kunnen worden gebruikt voor politieke propaganda of om personen of organisaties in diskrediet te brengen.

Voortdurend onderzoek naar de kwetsbaarheden van AI-systemen en de ontwikkeling van robuuste tegenmaatregelen zullen helpen om de potentiële schade door nepnieuws en deepfakes te beperken. Nauwe samenwerking tussen overheden, technologiebedrijven en cyberbeveiligingsdeskundigen zal hierbij van cruciaal belang zijn om ervoor te zorgen dat de technische robuustheid en veiligheidsproblemen van GenAI adequaat worden aangepakt.

Privacy en gegevensbeheer

GenAI-modellen worden getraind op enorme datasets, waaronder persoonlijke en auteursrechtelijk beschermde informatie, meestal afkomstig van het openbare internet. Het trainen van AI op auteursrechtelijk beschermde gegevens zonder toestemming kan leiden tot schending van het auteursrecht en de mogelijkheid dat AI-gegenereerde inhoud sterk lijkt op bestaande werken roept vragen op over originaliteit en schending van het auteursrecht.

Ethische GenAI-ontwikkeling moet gepaard gaan met duidelijke praktijken voor gegevensbeheer, waaronder een strikt beleid voor het verzamelen, opslaan en gebruiken van gegevens. Daarnaast is het essentieel om de onduidelijkheden rond auteursrecht en eigendom van door AI gegenereerde inhoud aan te pakken om een eerlijke omgeving te creëren die aan de wet voldoet.

Transparantie

GenAI-modellen worden vaak gezien als “zwarte dozen”, zonder transparantie in hun besluitvormingsprocessen. Deze ondoorzichtigheid roept zorgen op over eerlijkheid, controleerbaarheid en betrouwbaarheid, omdat het voor gebruikers en zelfs ontwikkelaars moeilijk kan zijn om te begrijpen hoe deze modellen tot hun conclusies komen.

Om de interne werking van deze “zwarte dozen” transparanter te maken, moeten er methoden worden ontwikkeld om de output van GenAI-modellen te interpreteren en te verklaren. Deze methoden kunnen bestaan uit het visualiseren van de interne werking van het model, het analyseren van de geleerde representaties en het testen van de output tegen echte gegevens.

Diversiteit, non-discriminatie en eerlijkheid

Een bijzonder controversiële kwestie die is ontstaan door het toenemende gebruik van GenAI heeft betrekking op de kwaliteit en diversiteit van de trainingsgegevens. Er zijn gevallen bekend van GenAI-modellen die werken met persoonlijke gegevens of afbeeldingen die seksuele of raciale stereotypen versterken of bepaalde groepen ondervertegenwoordigen.

Het aanpakken van deze vertekeningen vereist een zorgvuldig ontwerp, voortdurende evaluatie en verantwoorde selectie van trainingsgegevens.

Het is onvermijdelijk dat GenAI ook kan worden misbruikt door slechte actoren om aanstootgevende inhoud te genereren, waaronder discriminerende of gewelddadige afbeeldingen en teksten, neppornografie en terroristische propaganda. Een nepbeeld, waarschijnlijk gegenereerd met behulp van AI-tools, dat zogenaamd een grote explosie bij het Pentagon liet zien, werd onlangs op grote schaal verspreid op sociale media en beïnvloedde kortstondig de financiële markten.

Het waarborgen van diversiteit, non-discriminatie en eerlijkheid in GenAI-toepassingen is niet alleen een ethische noodzaak, maar ook cruciaal voor het bouwen van inclusieve en rechtvaardige AI-systemen.

Maatschappelijk en ecologisch welzijn

Gezien de opwinding en vaak verbazing die GenAI teweegbrengt, is het gemakkelijk om een aantal minder welkome gevolgen van de snelle invoering van deze technologie voor het milieu en de samenleving als geheel over het hoofd te zien.

GenAI-systemen vereisen aanzienlijke rekenkracht en er wordt geschat dat een ChatGPT-zoekopdracht 3-30 keer meer elektriciteit verbruikt dan een traditionele Google-zoekopdracht. De verwachte groei in GenAI zal dus gepaard moeten gaan met een gezamenlijke verschuiving naar het gebruik van hernieuwbare energiebronnen om de datacenters die dit soort toepassingen hosten van stroom te voorzien, wil de technologie de klimaatcrisis niet verergeren.

Een andere uitdaging die mogelijk gevolgen heeft voor alle menselijke werknemers is hoe GenAI de aard van het werk zal veranderen. Economen debatteren al een aantal jaar over de impact die robots en AI zouden kunnen hebben op sommige banen, met name banen met repetitieve taken die het gemakkelijkst te automatiseren zijn.

Om deze ethische implicaties aan te pakken is een meervoudige aanpak nodig, met inspanningen om de energievoetafdruk van AI-systemen te verminderen en initiatieven om de beroepsbevolking om te scholen en bij te scholen voor het veranderende banenlandschap.

Verantwoordingsplicht

Naarmate de toepassing van GenAI toeneemt, is er een duidelijke en dringende behoefte aan betere, preciezere regelgeving om het probleem van verantwoording aan te pakken.

De algoritmes die GenAI-systemen aansturen, creëren soms “hallucinaties” die nergens op slaan of waarvan kan worden aangetoond dat ze onjuist zijn. Een recent geval betrof een team advocaten in de VS die zich niet realiseerden dat ChatGPT de citaten en citaten had verzonnen die ze gebruikten in een rechtszaak.

Het integreren van menselijk toezicht in GenAI-systemen is niet alleen essentieel om hallucinaties te detecteren, maar ook om ethische besluitvorming te garanderen, mogelijke vooroordelen te verminderen en acties die onzinnig lijken aan te vechten.

In een volgende blogpost indeze serie bekijken we hoe één bepaald stuk wetgeving, de AI-wet van de EU, de hierboven genoemde kwesties probeert aan te pakken.