Ooit waren hardware en software sterk geïntegreerde onderdelen in een computersysteem. Nieuwe architecturen brachten een scheiding aan tussen de hardware en de software, met een onderverdeling tussen besturingssysteem en applicatiesoftware. Onder invloed van de virtualisatie trend is daar waar mogelijk de hardware functionaliteit vervangen door software. Op de computerstack neemt het aantal lagen tussen software en hardware sterk toe. In het cloud tijdperk lijken virtuele machines de grenzen van hun capaciteit te hebben bereikt. De werklast, ondergebracht in containers en ontkoppeld van de onderliggende infrastructuur, maakt de stack overzichtelijker en efficiënter.

Intesa Sanpaolo is een vooraanstaande bancaire instelling in Italië met een marktkapitalisatie van ruim 38 miljard euro, 5.000 kantoren en 19 miljoen klanten in 40 landen wereldwijd. Twee jaar geleden is de organisatie gestart met een transformatietraject voor het vergaand digitaliseren van de bedrijfsprocessen. Een belangrijk onderdeel daarvan is de migratie van softwaretoepassingen van een monolitische architectuur naar een container-architectuur met microservices. Daarmee moest de snelheid van applicatie-ontwikkeling worden verhoogd en de omvang van de applicaties worden verkleind ten behoeve van de flexibiliteit, schaalbaarheid en betrouwbaarheid.

Meervoudige clusters in on-premise omgeving

Het project stelde de vernieuwde IT-organisatie voor enorme uitdagingen bij het inrichten van de software containers. De IT-infrastructuur bleek een grote hinderpaal. De architectuur van microservices liet zich lastig opschalen over tijdzones en geografisch verspreide afdelingen. Daarnaast was het ontwikkelen en draaien van 3000 interne applicaties niet meer te managen. Voor de on-premise computervoorzieningen moest de bankorganisatie op zoek naar een andere Kubernetes-aanpak. Die werd gevonden bij het jonge technologiebedrijf Diamanti Inc, een cloud-native applicatiespecialist uit het Californische San Jose, die inmiddels ook een kantoor in Amsterdam bezit. De Italianen lieten zich een ’hyper converged’ platform onder Red Hat OpenShift aanmeten met een geïntegreerde controle over data en processen in de containers vanaf de I/O operatie van een enkelvoudige container tot aan meervoudige clusters in hun on-premise omgeving. Met Kubernetes ’on bare metal’ voorziet het platform in

Tom Barton, CEO Diamanti Inc.

orkestratiefunctionaliteit van containers rechtstreeks op de onderste laag (Linux) zonder de overhead en lock-in van virtual machines en hypervisors.

Tom Barton is de CIO van Diamanti Inc. Opgeleid aan Stanford University in Palo Alto, bouwde hij verder aan zijn technologie-carrière in Silicon Valley met functies bij zowel hardware- als software-georiënteerde bedrijven. Hij bekleedde managementposities bij Lightspeed Venture en Planet Labs alvorens aan boord te stappen bij de jonge onderneming in San Jose. Daar ondersteunt hij de twee technisch georiënteerde oprichters in het vercommercialiseren van hun innovatieve oplossingen, gericht op het optimaliseren van de werklast op servers met cloud-native toepassingen. ”De cloud is de plek waar 73% van de werklast naar toe gaat”, aldus Barton. ”Bij het overgrote deel van de nieuwe toepassingen gaat dat via cloud-native containers. Een feit is dat bij heel veel bedrijven er een tekort bestaat aan medewerkers met voldoende vaardigheden in cloud-technologie. En dat terwijl de markt snel groeit naar een waarde van naar schatting 143 miljard dollar. Volgens Gartner worden meer dan 50% van de nieuwe applicaties opgeleverd in containervorm. Wij zien dat binnen onze klantenkring van grote Fortune-500 bedrijven ongeveer een kwart de intentie heeft om bestaande applicaties te vervangen door containers en dat de meerderheid daarvan ook al containerapplicaties in productie hebben genomen”.

Containerisatie volgt virtualisatie op

Veel I/O kracht in klein formaat: 1.000.000+IOPS per 1U node.

Volgens de Diamanti CEO stonden de afgelopen 10 tot 15 jaar in het teken van virtualisatie in het datacenter. Hij verwacht dat bij datacenterautomatisering de komende jaren Kubernetes en containers de ontwikkelingen gaan bepalen. We zien het aan alle drie public cloud providers Microsoft, Amazon en Google. Die hebben via hun API’s een standaard gezet voor Kubernetes en containers. Zolang je hun API-richtlijnen volgt, draaien ze probleemloos elke werklast voor je. Bij onze Fortune 500 afnemers bespeuren we weliswaar veel belangstelling voor de public cloud, maar nog steeds in combinatie met hun on-premise installaties. Een cloud-native architectuur maakt het gemakkelijk om applicaties en data in containers automatisch tussen de verschillende platforms uit te wisselen. De overname van Red Hat door IBM is gericht op de cloudmigratie. In de onderneming op zich met de open source Linux-diensten zijn ze niet geïnteresseerd, maar wel in hun cloud-technologie OpenShift.”

Omdat door de Corona-crisis veel beurzen en andere vormen van productexpositie geen doorgang kunnen vinden, zijn de mogelijkheden verruimd om met Kubernetes containertechnologie online te experimenteren. Daartoe heeft men vanuit het Amsterdamse Diamanti-kantoor via de hosting-organisatie PK-Automatisering uit Assen een appliance-cluster geplaatst in een datacenter in Groningen. Inmiddels vinden er op Europese schaal diverse testen plaats met containers in combinatie met analytische toepassingen. ”Op infrastructureel niveau is ’Kubernetes on bare metal’ geknipt voor Red Hat OpenShift”, claimt Barton en vervolgt: ”De voordelen liggen in de sfeer van gebruiksgemak zoals: snelle uitrol van OpenShift en onderliggende infrastructuur; geen vendor lock-in; integratie met traditionele en cloud-native ecosystemen; gemakkelijk beheer en op- of afschalen van capaciteit.”

Offload van netwerk en storage dataverkeer

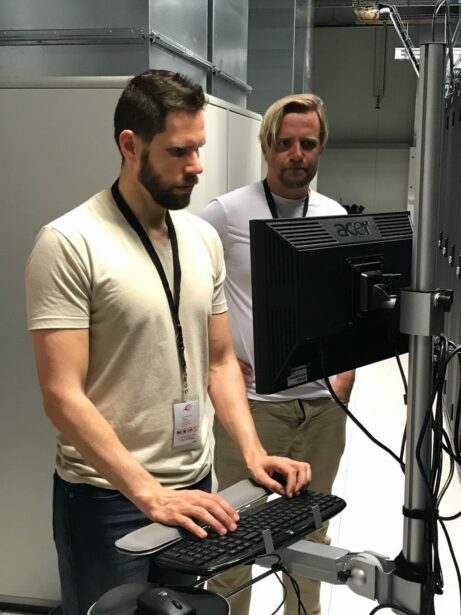

Diamanti medewerkers installeren de Kubernetes appliance in het Groningse datacenter.

De oplossing van de Californische scale-up onderscheidt zich door de ’offload’ faciliteiten via standaard plug-in PCI-e hardware van netwerk- en storage-dataverkeer op elk x86-platform. Applicatieverkeer via de implementatie van op SR-IOV (Single Root I/O Virtualization) gebaseerde ’data planes’ is op hardware-niveau volledig geïsoleerd van het host-netwerk en andere container-netwerken. Daarmee bewerkstelligt volgens Barton de technologie niet alleen een acceleratie in prestaties op de servers, maar draagt ook bij aan de beveiliging, zodat de effectiviteit van hacker-aanvallen dramatisch afneemt en de beschikbaarheid van data na een onverhoopte hack of een crash is gegarandeerd. Met de hardware komt gelijktijdig een software stack met volledige CNI- en CSI-functionaliteit (Container Network Interface; Container Security Initiative) en tevens voorzieningen voor netwerkisolatie, persistent geheugen, data-beveiliging, herstelprocedures en kwaliteitsbewaking, alsmede het beheer en orkestratie van containers.

”Ons platform laat zich prima gebruiken in combinatie met de nu gangbare, onder VMware draaiende servers”, zegt Barton. ”Wie echter wil besparen op energiekosten of de investeringslasten voor hardware, kiest eerder voor onze bare metal-aanpak.” Daarnaast wil Barton zijn bedrijf laten acteren als algemeen Kubernetes-dienstverlener. ”Nu leveren wij als Kubernetes gecertificeerde serviceprovider 24 x7 technische ondersteuning vanuit één contactpunt. En dat niet alleen voor het eigen Kubernetes-platform, maar ook voor alle andere, open source Kubernetes varianten, inclusief dus het Red Hat OpenShift-platform. Daardoor weten ontwikkelteams zich voldoende gesteund bij het oplossen van infrastructurele vraagstukken en kunnen zij zich focussen op het bouwen van applicaties.”

Panklare versneller van analytische applicaties

De Diamanti D20 RH appliance is volledig afgestemd op het bouwen en bedrijfsbreed uitrollen van applicaties in containers met behulp van het OpenShift Container platform. De appliance staat garant voor maximale prestaties, schaalbaarheid en doelmatige operationele inzet van Red Hat’s ontwikkeltool en platform voor containers en Kubernetes. De D20 RH voorziet OpenShift gebruikers binnen enkele uren van de onderliggende infrastructuur waardoor zij innovaties sneller tot stand brengen en daarmee competitieve voordelen behalen. Tegelijkertijd weet men zich op het operationele IT-vlak verzekerd van prestaties, efficiency en eenvoud in gebruik van de hyperconverged containerinfrastructuur.

D20 appliance cluster biedt ’offload’ faciliteiten via standaard plug-in PCI-e hardware van netwerk en storage dataverkeer op elk x86 platform.

De gevirtualiseerde aanpak bij het beheer van storage- en netwerkverkeer richt zich volledig op de vereisten van container applicaties die over redundante opslagvoorzieningen moeten beschikken. De technologie zorgt voor een optimaal gebruik van systeembronnen (95% over de gehele cluster). Geen enkel platform van geringe afmeting binnen een datacenter levert soortgelijke prestaties. De block storage, gebaseerd op Intel NVMe, functioneert met een uiterst lage vertraging van 100 microseconden bij het uitvoeren van lees/schrijf opdrachten en gebruikt maar voor een derde van de transactionele CPU- overhead bij SCSI-connecties. Diamanti breidt de NVMe-functionaliteit uit over de cluster met gebruik van 10 GB Ethernet-verbindingen en vergroot daarmee de mobiliteit van de data. Op deze manier ontlast de appliance IT-specialisten van de complexiteit bij het configureren van poort mappings, netwerk overlays en de bandbreedte. De voorhanden netwerkfaciliteiten sluiten direct aan op de bestaande netwerkinfrastructuur. Elke container krijgt automatisch een IP-adres toegewezen en kan daardoor op elk subnet functioneren.

De storage arrays waarmee ’legacy’ systemen opschaalden, passen niet meer in het moderne schaalproces van containerverwerking. Om toch bij het draaien van database applicaties voldoende prestaties te halen en te kunnen opschalen naar de gewenste schaalgrootte worstelen de ops-teams van IT-afdelingen voortdurend met de vraag naar persistent geheugen. Diamanti komt tegemoet aan die vraag van storage voor applicaties met redundante opslag. Een multi-cloud container infrastructuur laat zich gemakkelijk opschalen. Één appliance is goed voor 1.000.000+IOPS (I/O operaties per seconde) per 1U node (standaard rack-formaat appliance behuizing) en maximaal 100-microseconde vertraging (latency). Daardoor zijn servicegaranties (QOS) af te geven met een voor containers essentiële minimale doorlooptijd.

Multi-zone clustering voorzieningen zorgen voor uitbreiding van de fouttolerante eigenschappen en het vergroten van de beschikbaarheid bij het inrichten van een containeromgeving. Daarmee laat zich de werklast automatisch verdelen over een reeks van zones met beschikbare verwerkingscapaciteit. Zowel de testomgevingen als de huidige operationele toepassingen tonen dat de prestatieverbetering van de appliance vooral tot zijn recht komt bij ’zware’ database applicaties en analytische toepassingen (Elastic, Splunk en Kafka).