Cybercriminelen gebruiken steeds vaker spraakberichten voor phishingaanvallen, ook wel bekend als ‘vishing’. Deze aanvalsmethode bereikt een piek in 2020. Daarvoor waarschuwt Mimecast in zijn nieuwe Threat Intelligence-rapport. De securityspecialist wijst daarnaast op de toenemende dreiging van aanvallen met deepfake-audio: het nabootsen van stemmen met kunstmatige intelligentie.

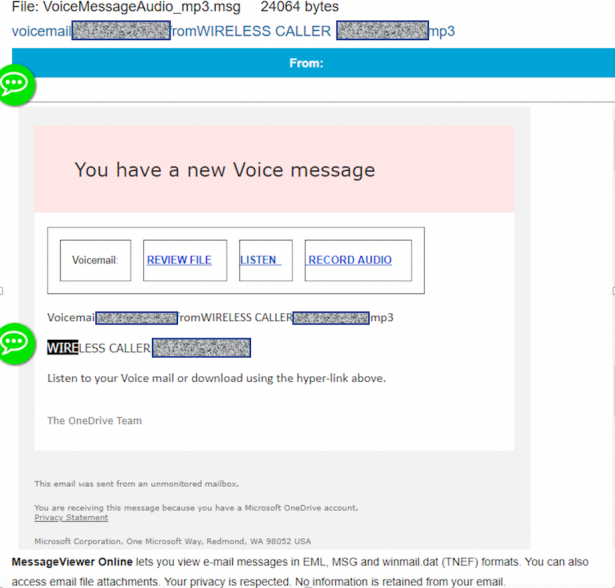

Vishing (een samenstelling van voice en phishing) kent verschillende verschijningsvormen. Een voorbeeld is een e-mail met in de bijlage een mp3-bestand waarin de gebruiker wordt gevraagd om een bepaalde actie te ondernemen. Maar Mimecast ziet ook aanvallen waarbij een spraakbericht als lokmiddel fungeert. Als de ontvanger het spraakbericht wil openen, worden er knoppen getoond zoals ‘beluister’ en ‘audio opnemen’ die leiden naar een phishing site. Het gaat hier om vrij eenvoudige aanvallen die met technologie grotendeels te automatiseren zijn.

De combinatie van spraak met kunstmatige intelligentie maakt ook verfijndere aanvallen mogelijk. Zo meldde de Wall Street Journal in september dat een Brits energiebedrijf voor 220.000 euro is opgelicht met zogeheten deepfake-audio. De CEO dacht dat hij een telefoongesprek had met de CEO van het Duitse moederbedrijf. Hij kreeg het verzoek om met spoed een bedrag over te maken naar een Hongaarse leverancier. In werkelijkheid werd de stem zeer overtuigend nagebootst met behulp van AI-technologie.

Interactief en levensecht

“Bij de eerste gefotoshopte afbeeldingen was duidelijk te zien dat er iets niet klopte”, zegt Jonathan Miles, threat intelligence-expert bij Mimecast. “Dat geldt nu ook voor de productie van deepfake-audio. De meeste aanvallers maken hiervoor gebruik van relatief simpele software. De spraakberichten en stemmen die daarmee worden gegenereerd, klinken niet erg overtuigend. Maar cybercriminelen die veel financiële middelen hebben, kunnen geavanceerdere software betalen. Dan klinkt een nagebootste stem opeens levensecht.”

“Naarmate de technologie volwassener wordt, zal het ook steeds makkelijker en goedkoper worden om geloofwaardige audiocontent te ontwikkelen”, vervolgt Miles. “Aanvallers kunnen algoritmes bijvoorbeeld voeden met stemopnames die ze van YouTube halen. En als je dan ook nog een platform gebruikt dat tekst automatisch omzet naar spraak in een nagebootste stem, wordt het mogelijk om zeer geloofwaardige, interactieve dialogen te voeren. Social engineering krijgt hierdoor een nieuwe dimensie.”

Hoe beperken we de risico’s?

Mimecast geeft bedrijven en hun medewerkers een aantal tips om schade door dergelijke aanvallen te voorkomen:

- Open geen spraakberichten en andere audiobestanden die binnenkomen via e-mail en klik niet op links in dit soort e-mails.

- Pas niet zomaar betaal- of accountgegevens aan zonder goedkeuring van de verantwoordelijke manager(s). Zeker niet op verzoek van iemand die zich plotseling via e-mail of telefonisch bij u meldt.

- Wordt u gebeld door iemand met een onbekend nummer die claimt een hoge managementfunctie te vervullen? Bel dan ter controle eerst terug naar een bekend telefoonnummer van die persoon.

- Wees u ervan bewust dat een stem tegenwoordig na te bootsen is. Het feit dat u een stem herkent, zegt niets over de betrouwbaarheid.

- Stel uzelf altijd de vraag: is dit een normaal verzoek? Laat u niet onder druk zetten om mee te werken als u sceptisch bent.

“Het is niet eenvoudig om vishing of een poging tot oplichting met deepfake-audio te herkennen”, besluit Miles. “Vooral deepfake-audio is een relatief nieuw verschijnsel. Waarschijnlijk hebben veel werknemers er nog nooit van gehoord. Juist daarom is het cruciaal om regelmatig securitytrainingen te organiseren waarin dit soort nieuwe bedreigingen aan bod komen.”

Het Threat Intelligence-rapport van Mimecast beschrijft het huidige en toekomstige dreigingslandschap voor bedrijven. U kunt het volledige rapport downloaden via deze link.