Cloudflare heeft nieuwe mogelijkheden aangekondigd voor Workers AI en de beschikbare bouwstenen voor het ontwikkelen van AI-apps. Workers AI is het serverloze AI-platform waarmee ontwikkelaars nu nog snellere, krachtigere en beter presterende AI-apps kunnen maken. Apps die op Workers AI zijn gemaakt, profiteren onder andere van snellere inferentie, grotere modellen en betere prestatiestatistieken. Workers AI is het eenvoudigste platform om wereldwijde AI-apps te maken en AI-inferentie dichter bij de gebruiker uit te voeren, waar ter wereld die zich ook bevindt.

Netwerklatentie verminderen

Aangezien large language models (LLM’s) kleiner en sneller worden, is de netwerksnelheid het knelpunt voor klanten die de LLM’s willen gaan gebruiken en naadloze interacties met AI willen ervaren. Cloudflare’s wereldwijde netwerk helpt netwerklatentie te verminderen. Het onderscheidt zich hiermee van andere netwerken die meestal uit geconcentreerde bronnen in een beperkt aantal datacenters bestaan. Cloudflare’s serverloze inferentieplatform, Workers AI, beschikt nu over GPU’s in meer dan 180 steden in de hele wereld. Het is gemaakt voor wereldwijde toegankelijkheid, zodat eindgebruikers van over de hele wereld van een lage latentie kunnen profiteren. Met dit netwerk van GPU’s is Workers AI een van de grootste wereldwijde AI-platforms. Workers AI is ontworpen om AI-inferentie lokaal en zo dicht mogelijk bij de gebruiker uit te voeren, zodat klantgegevens dichter in de buurt blijven.

“Terwijl AI het afgelopen jaar populair werd, dacht niemand dat netwerksnelheden tot AI-latentie zouden leiden. Het ging hierbij immers om nieuwe, experimentele interacties. Maar naarmate AI een steeds grotere rol in ons dagelijks leven speelt, worden het netwerk en milliseconden van cruciaal belang”, zegt Matthew Prince, medeoprichter en CEO van Cloudflare. “Terwijl AI-workloads van training naar inferentie opschuiven, worden de prestaties en regionale beschikbaarheid van essentieel belang om de volgende fase van AI te ondersteunen. Cloudflare is het meest wereldwijde AI-platform op de markt. GPU’s in steden overal ter wereld zullen AI van een nieuw technisch snufje omvormen tot een onderdeel van ons dagelijks leven, net zoals sneller internet dat voor smartphones heeft gedaan.

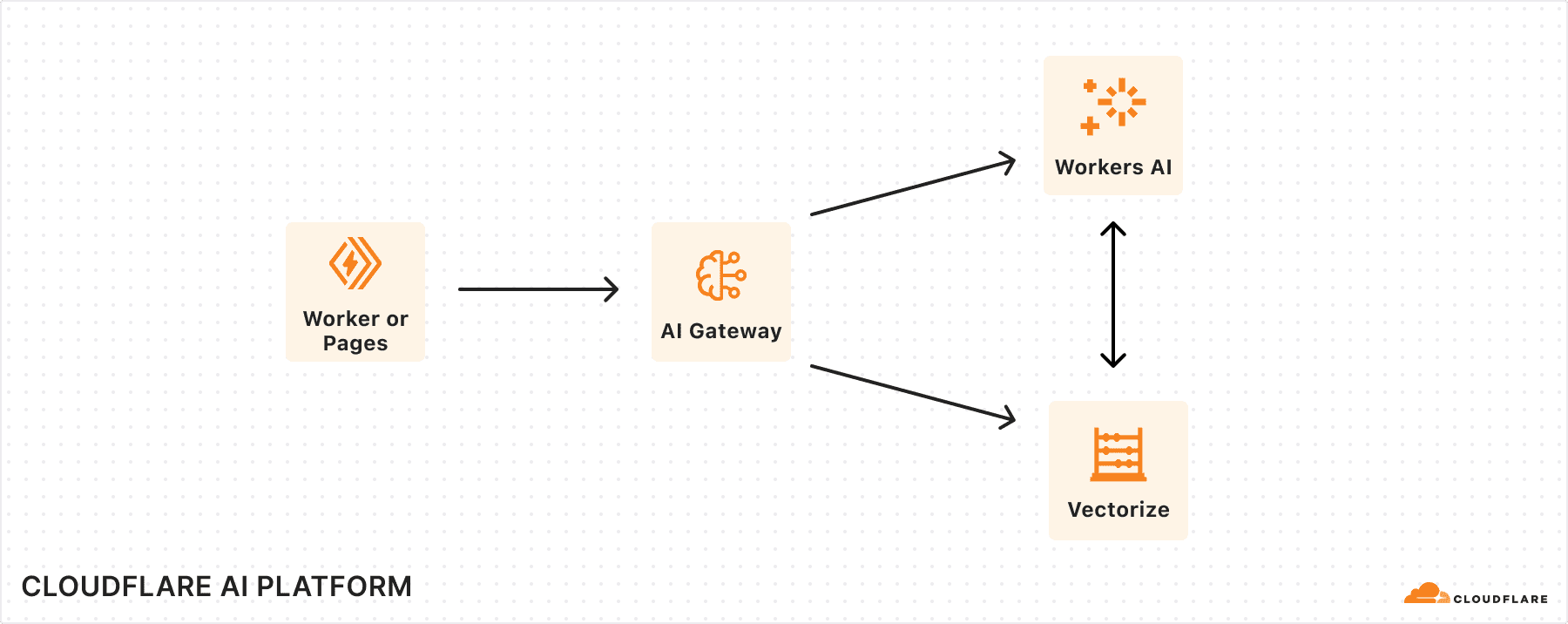

Cloudflare introduceert ook nieuwe mogelijkheden waarmee Workers AI het eenvoudigste platform wordt om AI-apps mee te maken:

- Betere prestaties en ondersteuning voor grotere modellen: Cloudflare breidt zijn wereldwijde netwerk nu uit met krachtigere GPU’s, zodat Workers AI sneller de AI-inferentie kan uitvoeren op aanzienlijk grotere modellen, zoals Llama 3.1 70B en de collectie Llama 3.2-modellen met 1B, 3B, 11B (en binnenkort 90B). Dankzij ondersteuning voor grotere modellen, snellere responstijden en grotere contextvensters, kunnen AI-apps die op Workers AI van Cloudflare zijn gemaakt complexere taken efficiënter uitvoeren. Dit resulteert in natuurlijke, naadloze ervaringen voor eindgebruikers.

- Verbeterde controle en optimalisering van AI-gebruik met permanente logs: Dankzij nieuwe permanente logs in AI Gateway, beschikbaar in open bèta, kunnen ontwikkelaars prompts van gebruikers en antwoorden van modellen langer opslaan. Daardoor kunnen ze beter analyseren en begrijpen hoe hun app presteert. Permanente logs bieden ontwikkelaars uitgebreid inzicht op basis van gebruikerservaringen, bijvoorbeeld in de kosten en duur van verzoeken. Dit stelt hen in staat om hun app te verbeteren. Sinds de lancering van afgelopen jaar heeft AI Gateway al meer dan twee miljard verzoeken verwerkt.

- Snellere en betaalbaardere zoekopdrachten: Vectordatabases maken het makkelijker voor modellen om eerdere inputs te onthouden. Zo kan machine learning praktisch worden ingezet voor zoekfuncties, aanbevelingen en tekstgeneratie. De vectordatabase van Cloudflare, Vectorize, is nu algemeen beschikbaar. Sinds augustus 2024 ondersteunt deze database indexen van maximaal vijf miljoen vectoren, ten opzichte 200.000 daarvoor. De gemiddelde latentie van zoekopdrachten is nu nog maar 31 milliseconden (ms), ten opzichte van 549 ms in het verleden. Dankzij deze verbeteringen kunnen AI-apps snel relevante informatie vinden, terwijl ze minder gegevens hoeven te verwerken. Dit zorgt er ook voor dat AI-apps betaalbaarder worden.